Redes Neuronales, Pasos principales de Backpropagation

Jump to navigation

Jump to search

WARNING: Esta página está en desarrollo, puede contener errores.

- Se inicializan hyperparametros

- Alpha: valor numérico que se usa para gradient descent para avanzar.

- Cantidad de iteraciones

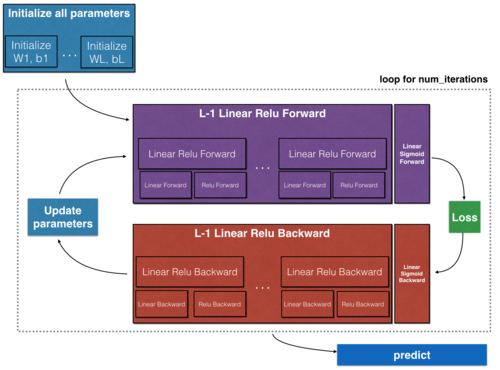

- Inicializar Parametros

Se les da un valor aleatorio a los parámetros para que no sean todos iguales a 0. -

Se realiza una cantidad de iteraciones del siguiente proceso

Este proceso acerca a lo más posible a 0 el costo de la suma de las predicciones. Con cada iteración se acerca más aunque puede estancarse cercano a algun valor. No necesariamente es un numero cercano a 0 (dependiendo del modelo y de la información puede ser un numero muy grande).- Usando los parámetros se hace un forward propagation (propagación hacia adelante) para cada ejemplo de entrenamiento de la información.

- Se computa el costo usando el forward propagation. (INSERTAR FORMULA DE COSTO)

- Se deriva el costo con relación a cada parametro.

- Se realiza gradient descent

Para cada parametro: al valor más reciente se le resta el valor de su derivada y se actualiza el parametro con este nuevo valor.

- El ultimo valor de los parámetros se usa para hacer nuevas predicciones.